Így látják a világot a Toyota autonóm járművei

A világ kutatóinak rendelkezésére bocsátja különleges videofelvételeit a Toyota. A nyersanyag új fejezetet nyithat a gépi tanulás, a szituáció-értelmezés és a viselkedés-előrejelzés terén, és felgyorsíthatja az autonóm mobilitási kutatásokat, fejlesztéseket.

Az autonóm mobilitás – azaz az emberi felügyelet nélkül megvalósuló közúti közlekedés – ígérete az évtized talán legizgalmasabb, ugyanakkor laikusok számára legkevésbé értelmezhető technológiai kihívása. A témával foglalkozó szervezetek minden eddiginél szorosabb együttműködéssel igyekeznek felgyorsítani a kutatás és fejlesztés folyamatát; a kooperációban élen jár a Toyota Motor Corporation, amely most újabb, különösen értékes információkat tett elérhetővé a szakemberek és a széles nyilvánosság számára.

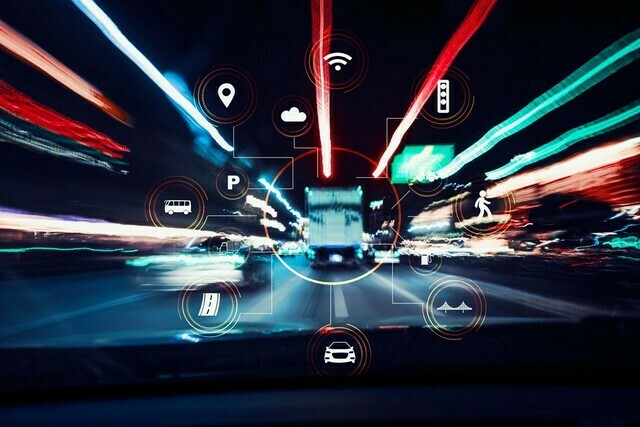

A gyártók régóta szemléltetik állóképekkel azt a „párhuzamos valóságot”, amelyet a robotautókat vezérlő szoftver észlel a világunkból. Az önjáró gépkocsik mesterséges agyának tulajdonképpen elég az akadályokat és a lehetséges útvonalakat észlelnie: ezeket különálló blokkokként azonosítja, így téve lehetővé a biztonságos manőverezést. A legtöbb környezeti objektum azonosítása nem okoz gondot: egy emberalak, egy gépkocsi vagy egy jelzőtábla kontúrjai kellően jellegzetesek ahhoz, hogy ne kelljen azokat hosszasan elemeznie a szoftvernek.

Egészen más azonban a helyzet az olyan, nehezen általánosítható jelenségekkel, mint az út menti növényzet, az útlezárás vagy építkezés: a szélfútta lombozat folyton változó körvonalai, az út szélén felhalmozott törmelék amorf kupaca komoly kihívást jelenthetnek az autonóm vezérlő technológiák számára. A mindenkori konkrét egyezések helyett szabályszerűségeket, valószínűségeket kell felismerniük a gépeknek. Ilyenkor jóval nagyobb adatmennyiségre van szükség a hatékony tanuláshoz: a járműveknek meg kell tanulniuk összefűzni és folytonos egységként értelmezni az adott területről készült felvételek sorozatát (magyarul: mozgófilmet). Ez azonban csak az érem egyik oldala; ahhoz ugyanis, hogy a kutatók megérthessék és támogathassák a tanulási folyamatot, ugyanazt kell látniuk, amit az autó is lát.

Ezért úttörő jelentőségű az a nyersanyag, amelyet a Toyota együttműködésre épülő biztonsági kutatóközpontja (Toyota Collaborative Safety Research Center, CSRC) a Massachusetts Institute for Technology (MIT) két tudományos kutatási részlegével együttesen hozott létre és tett ingyenesen elérhetővé kutatók és érdeklődők számára.

Az egyik adathalmaz egy 167 másodperces videó, amelyet városi utcákon rögzítettek a jármű kamerái: ennek 5000 képkockáját egyenként, pixelenként színezték be a kutatók, lehetővé téve, hogy az autonóm vezérlő szoftver megértse az összefüggéseket.

Ennél is izgalmasabb az a 67 darab, egyenként tíz másodperces filmszegmens (összesen 20 ezer 100 képkocka), amelyet nem a kutatók, hanem egy fejlett számítógépes program jelölt meg képpontról képpontra. A folyamatot egyelőre félig tudták automatizálni, ám ez is fontos állomás a végső cél (azaz a teljesen automatizált, gyors, pontos és költséghatékony elemzés) felé vezető úton.

A DriveSeg névre keresztelt folyamat hosszú távon lehetővé teszi annak vizsgálatát, hogy egyrészt lehetséges-e, másrészt célravezető-e nagy mennyiségű, valós forgalmi környezetben rögzített képanyag részletes címkézése: egyszóval, hogy az eljárás hozzásegíti-e az autonóm gépkocsik vezérlésére felkészülő mesterséges intelligenciákat a pontosabb, biztonságosabb vezetésre.

Ennek eldöntésében és a további vizsgálatokban az egész autonóm mobilitási kutatóközösség támogatására számít a Toyota és az MIT: az adatok közzétételével kiterjeszthetők a kutatások, és jelentősen felgyorsítható a fejlesztési folyamat.

Fotók: Toyota, MIT, Forbesimg